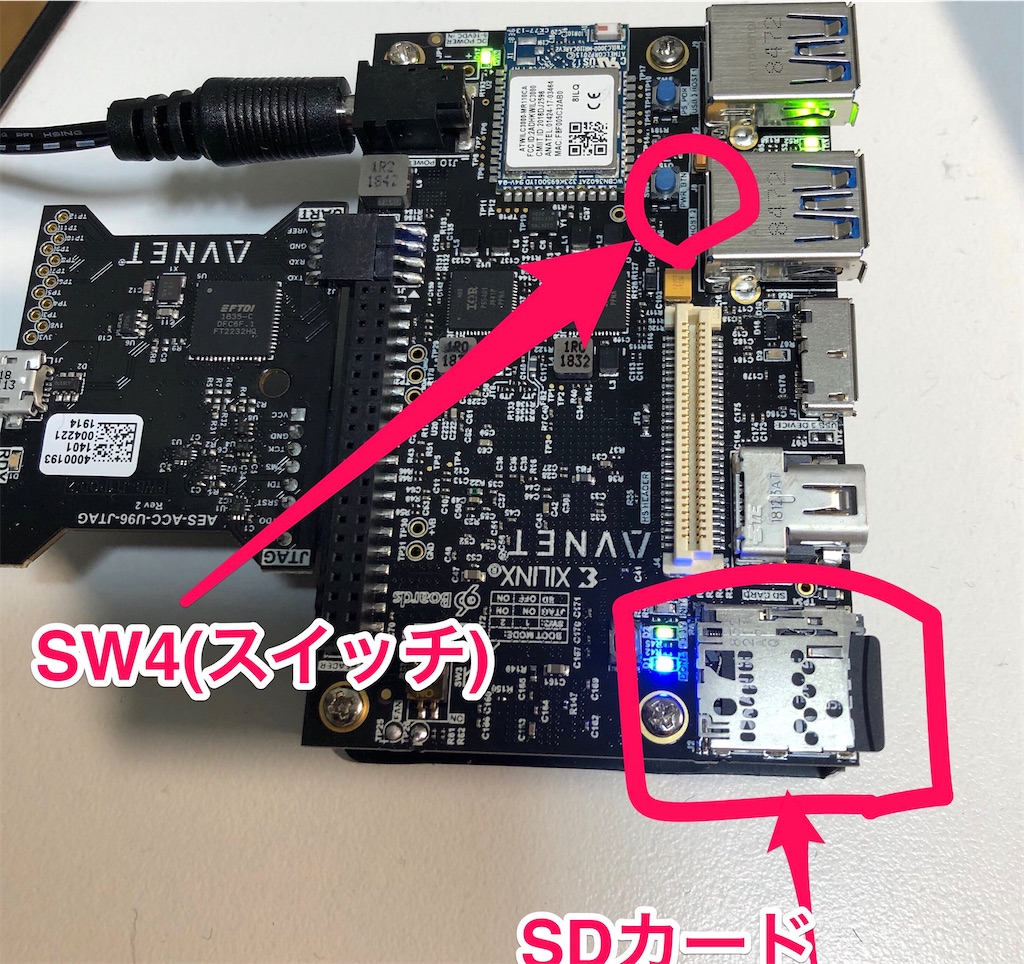

・1.ultra96-v2動作に必要なもの

「はじめてのUltra96 必要なもの」によると、Ultra96-v2に必要なものは、買った付属品以外に、

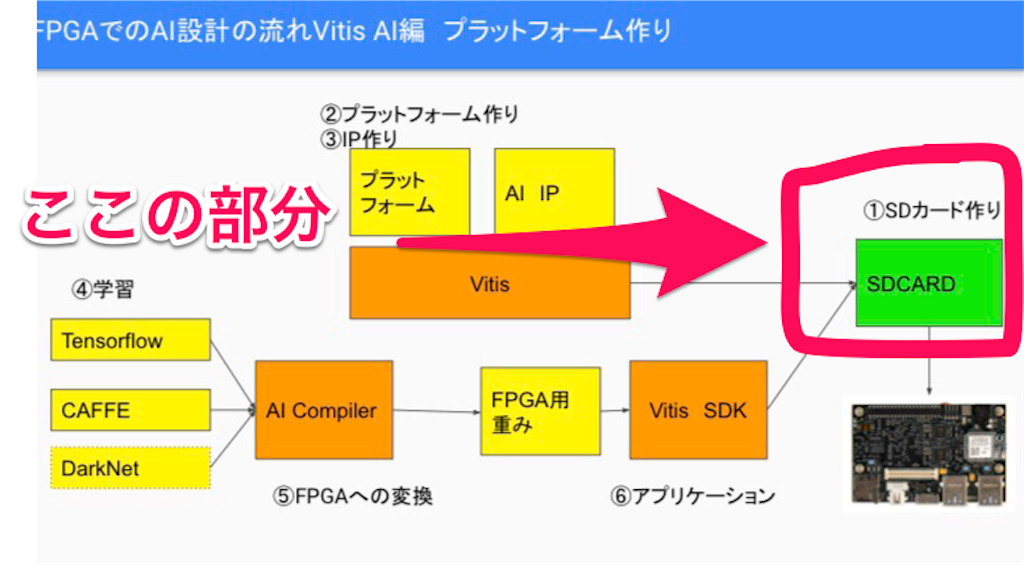

・「Vitisプラットフォーム(vitis IDE)」という開発環境の構築

・環境構築用OS ubuntu

が必要らしい。

・2.まず自分がやること

Ultra96-v2でAIを動かすことための「GPUが必要、仮想環境はダメっぽい」など面倒な課題はあとでなんとかするとして、

・大容量の外付けHDD

・ubuntu環境

を用意して、とにかく「vitisプラットフォーム」を外付けHDDの中に構築することにした。

・3.この記事でやること

そのために、自分がこの記事でやることは下の通り(仮想環境と外付けHDDをマウントするまでの流れ)。

この作業の備忘録をまとめてく。

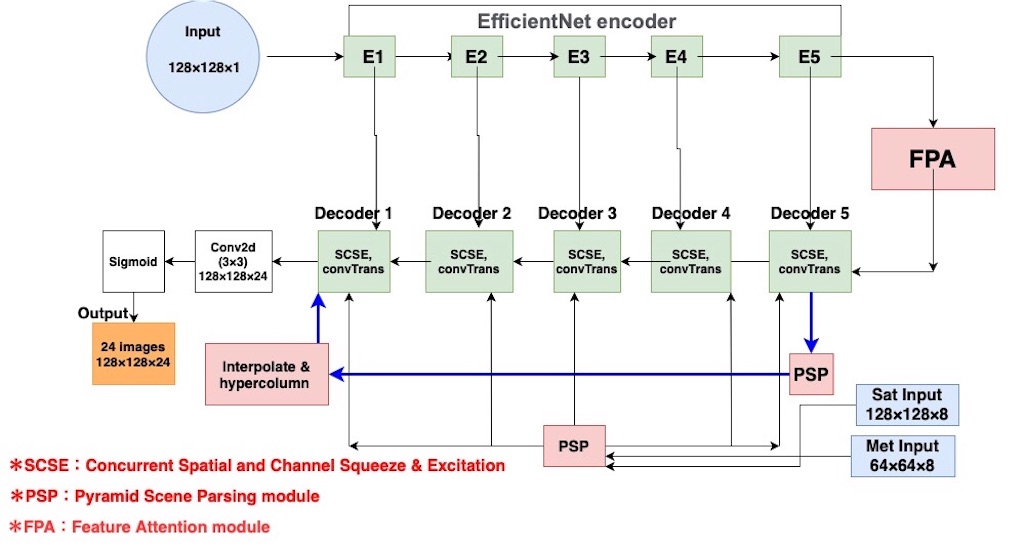

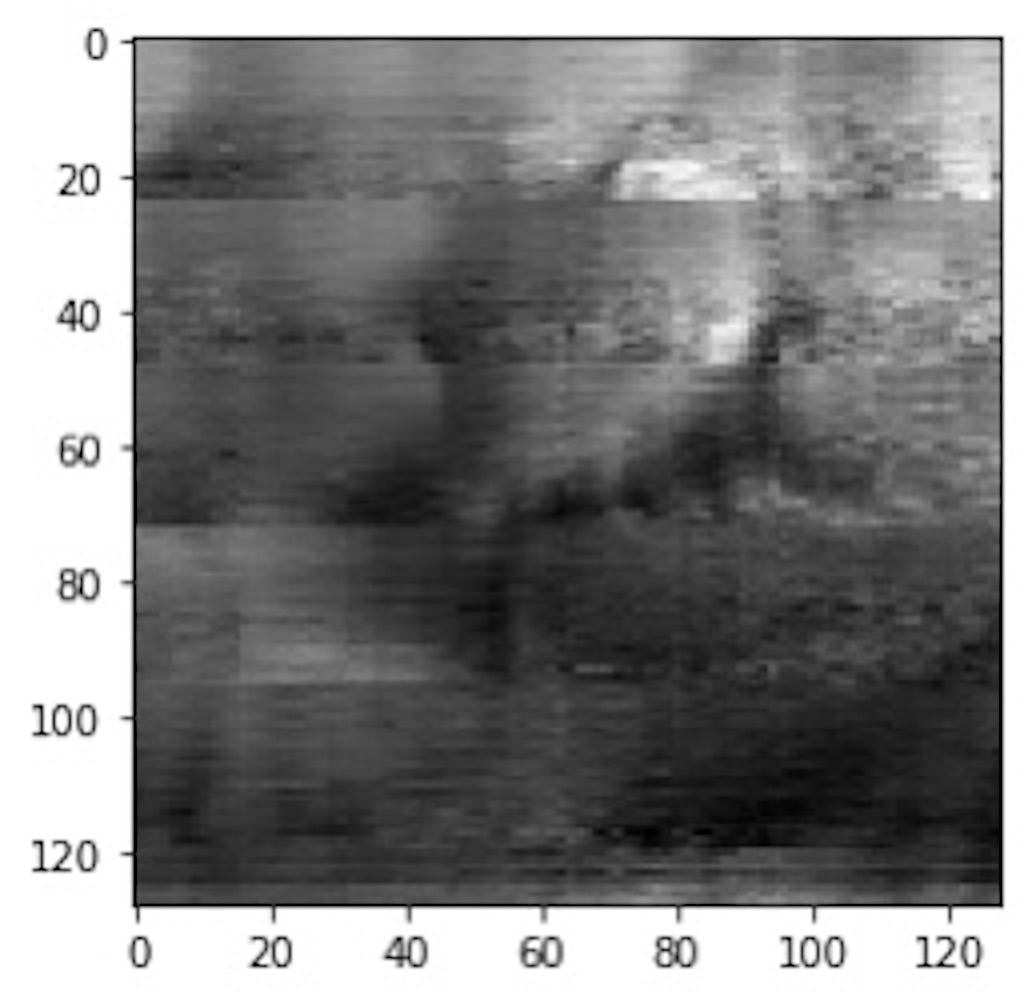

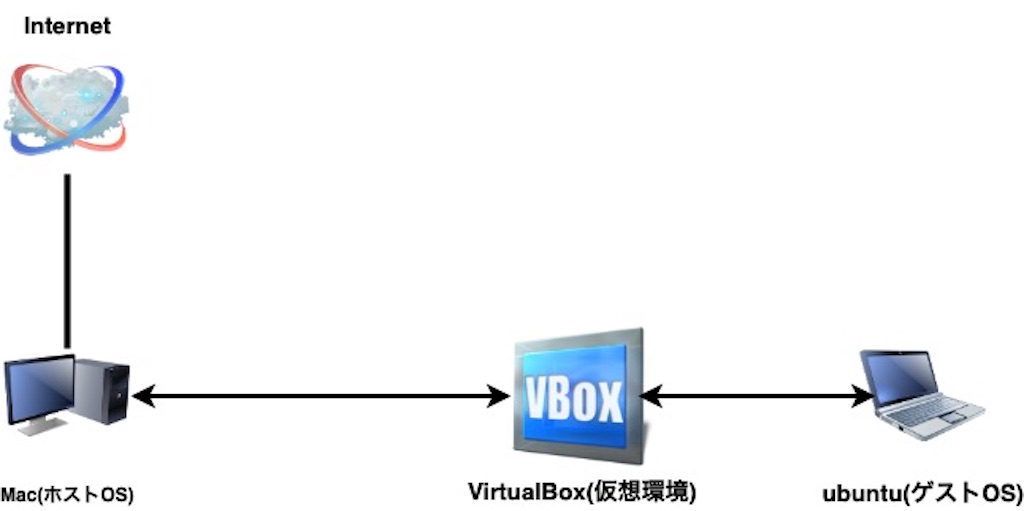

作成するネットワーク全体像

*注:Macを以下「ホストOS」、ubuntuの仮想環境を「ゲストOS」と表記。

目次

1.VirtualBoxの仮想環境にubuntuをインストールする

2.ホストOSからsshでログインするため、ゲストOS内でネットワーク設定

3.ホストOS側の外付けHDDをゲストOS側とマウント

1.VirtualBoxの仮想環境にubuntuをインストールする

ほぼ「MacにVirtualBoxでUbuntuを立てる方法【画像での解説つき】」の通りにやった。1.VirtualBoxのインストール & ubuntuをダウンロード

VirtualBox、Mac用のubuntu for desktopは以下からdownload。

ubuntuのバージョンは「Ubuntu Linux 16.04.5 LTS, 16.04.6 LTS, 18.04.1 LTS, 18.04.2 LTS (64 ビット)」のどれか。

ここでは18.04.2 LTS (64 ビット)を選択。

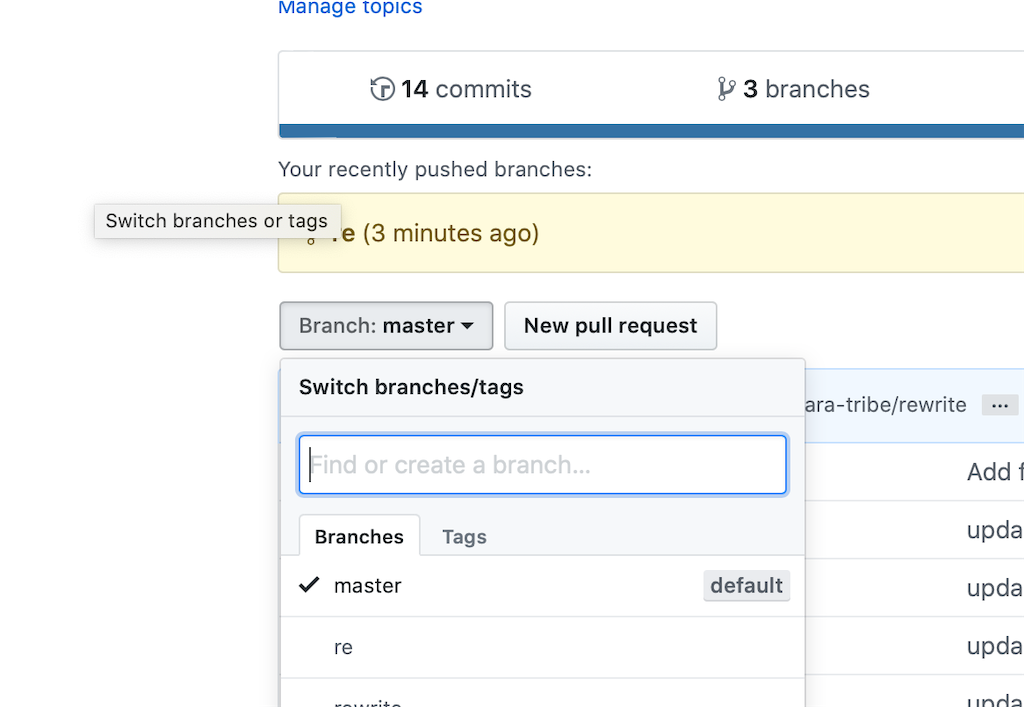

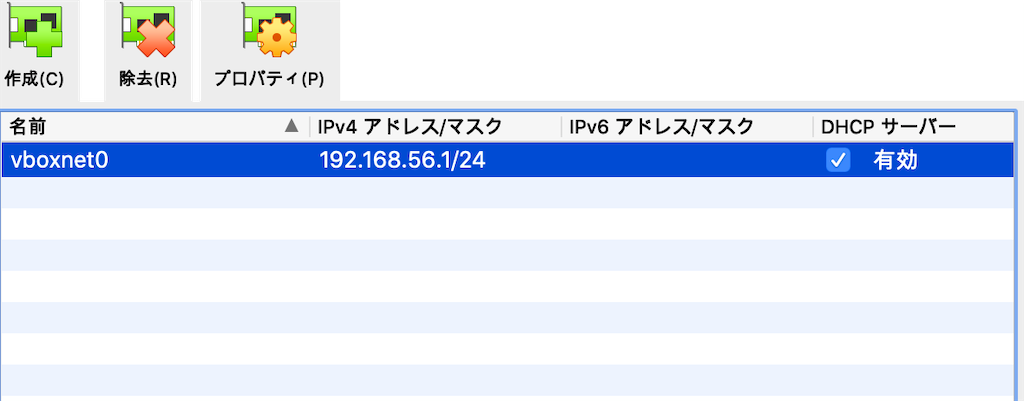

2.VirtualBoxのネットワーク(ホストオンリーネットワーク)の作成

サイトを参考に、virtualboxでネットワーク設定(ホストオンリーネットワークで「vboxnet0」を作成)。

VirtualBox起動=>「ファイル」=>「ホストネットワークマネージャー」=>「vboxnet0」の作成と有効化。

次にVirtualBoxからネットワークの設定。「ネットワーク」のアダプター1と2を以下の図のように設定。

3.VirtualBox起動してubuntuのインストール

ubuntuのインストール画面では、容量を節約するため「最小のインストール」を選択した。

・「最小のインストール」:ソフトウェアのみがインストール

後はサイト通りにインストールすればOK。

ubuntuをインストール中

# 例:ubuntuアカウント Your name: Ls PC name: Ls-VirtualBox User name: Ls Pasward: Ls11

2.ホストOSからsshでログインするため、ゲストOS内でネットワーク設定

1.ubuntu内のターミナルでネットワーク設定

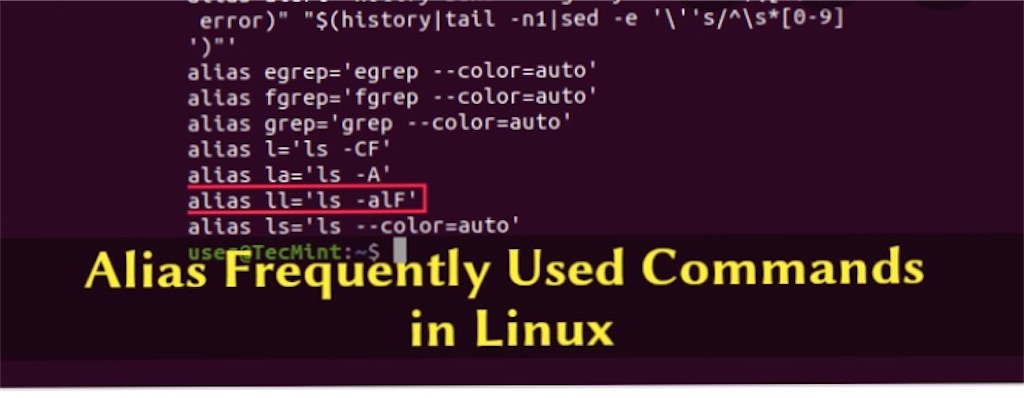

# vimとopenssh-serverのインストール $ sudo apt-get install vim openssh-server # ubuntuでadressの確認 $ ip address show # /etc/network/interfacesの編集 $ sudo vi /etc/network/interfaces # 下のように書き込んで、「esc+:wq」 auto enp0s3 iface enp0s3 inet static address 192.168.56.104 netmask 255.255.255.0

その後、GUIで再起動

参考サイト:Ubuntu18.04だとifconfigコマンドが標準で使えない?

2.ホストOS側ターミナルからゲストOSにsshでログイン

さっきのubuntuアカウントのYour nameと、/etc/network/interfacesの編集で使ったaddressでログイン。

# ssh [アカウント名]@[address] $ ssh Ls@192.168.56.104 >>> Welcome to Ubuntu 18.04.4 LTS (GNU/Linux 5.3.0-28-generic x86_64) * Documentation: https://help.ubuntu.com * Management: https://landscape.canonical.com * Support: https://ubuntu.com/advantage * Canonical Livepatch is available for installation. - Reduce system reboots and improve kernel security. Activate at: https://ubuntu.com/livepatch 70 個のパッケージがアップデート可能です。 57 個のアップデートはセキュリティアップデートです。 Your Hardware Enablement Stack (HWE) is supported until April 2023. The programs included with the Ubuntu system are free software; the exact distribution terms for each program are described in the individual files in /usr/share/doc/*/copyright. Ubuntu comes with ABSOLUTELY NO WARRANTY, to the extent permitted by applicable law.

ログインできた。

ここまでのネットワーク全体像

3.ホストOS側の外付けHDDをゲストOS側とマウント

ホストOS側で大容量の外付けHDDを差し込んで、vitisをインストールする場所にした。

vitisのインストールには110GBくらい必要なので、大容量の外付けHDDを選択。

自分が選んだのは1TBある、BUFFALOの外付けHDD

最終的に「vitisプラットフォーム」構築は、

・ゲストOS側(ubuntu環境)から外付けHDDの中に「vitisプラットフォーム」を作成する

という流れ。

1.ホストOS上でマウント用フォルダの作成

ホストOS上で、外付けHDDを差込み、中にマウント用ファルダ「ubuntu_mount」を作成。

外付けHDDの中身

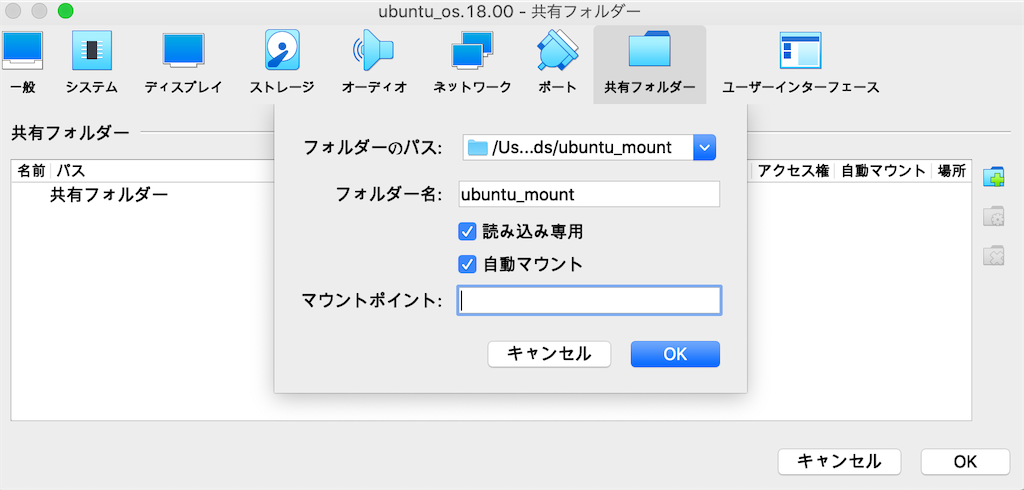

2.VirtualBoxで外付けHDDの「ubuntu_mount」を「共有フォルダー」に設定

「ubuntu_mount」のパスを確認。(外付けHDDのパスはディスクユーティリティから確認)

$ cd /Volumes/BuFFALO && ls Xlinx other ubuntu_mount $ cd ubuntu_mount && pwd /Volumes/BuFFALO/ubuntu_mount

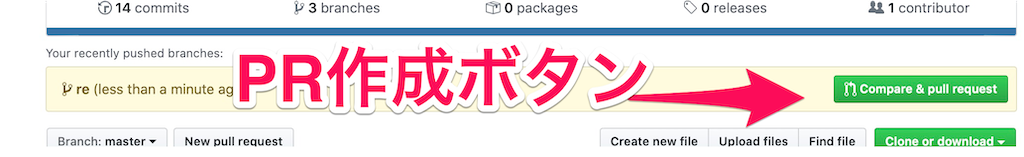

VirtualBoxで仮想マシンを選択=>「設定」=>「共有フォルダー」

=>右のフォルダマークをクリック=>下のようにパスとかを入れる

=>「"読み込み専用"のチェックを外す」=>「OK」クリック

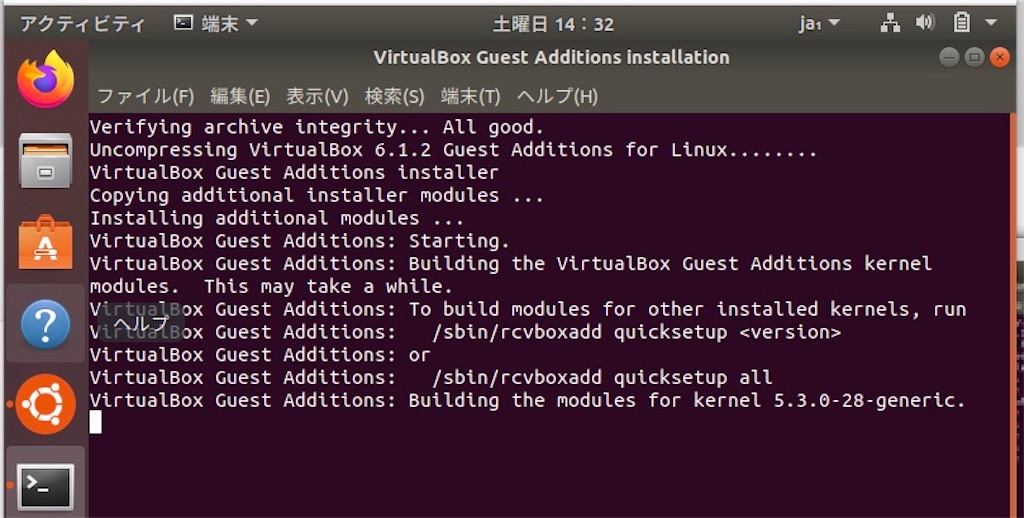

3.「Guest addtions」をubuntuにインストール

ubuntuでマウントを完了するには「Guest addtions」のインストールが必要。

VirtualBoxからubuntuを起動して、上の「Decices」=>「Insert Guest Addition CD Image~」をクリック。

次に、ubuntu上の画面に表示された「Guest addtions」のソフトウェアを実行。

Returnをクリックしてインストール完了。

その後、GUIで再起動。

再起動した後に、ubuntuの「/media」に移動したところ、マウント用に作成されたフォルダ(sf_[マウントするフォルダ名])があって、ちゃんとマウントされてる。

$ cd /media && ls sf_ubuntu_mount

***「Guest addtions」が入らない場合

ターミナルでこのコマンドを実行すれば、同じのが入る

sudo apt-get install virtualbox-guest-utils

参考:Unable to Install Guest Additions CD Image on Virtual Box

これで、ホストOS側の外付けHDDをゲストOS側とマウントするネットワークができた。

完成図

次記事でこの外付けHDDの「ubuntu_mount」の中に、ゲストOS側から「vitisプラットフォーム」を作ってく予定。

メイン参考サイト